по белому

по черному

Экс-сотрудник Yahoo убил мать и покончил с собой после общения с ChatGPT

В США, после общения с ботом ChatGPT, мужчина убил свою мать, а после покончил с собой. Об этом сообщает РИА «Новости».

Согласно имеющейся информации, речь идет о 56-летнем мужчине, который раньше работал в компании Yahoo. Сообщается, что весной этого года его начали посещать параноидальные идеи.

В частности, мужчина был уверен в том, что за ним ведется слежка и его мать тоже в этом замешена.

Возможно, что при других обстоятельствах он бы обратился за медицинской помощью или его странные идеи настолько вызывали бы беспокойство у окружающих, что они бы как-то вмешались. Но все пошло по другому сценарию: мужчина решил спросить совет у нейросети и та лишь укрепила его веру в то, что подозрения о слежке не являются бредом и со здравомыслием у этого человека нет никаких проблем.

Закончилось все трагично: сперва мужчина убил свою мать, а после покончил с собой.

Стоит отметить, что в последнее время люди все больше начали доверять нейросетям и чат-ботам. При этом наблюдается довольно пугающая тенденция: при депрессии или других проблемах с ментальным здоровьем люди все чаще именно к виртуальному собеседнику, а не к человеку с соответствующим образованием.

В результате последствия могут быть весьма трагичными и закончиться чьей-то смертью.

Можно ли считать случившееся виной ИИ или его разработчиков – сложный вопрос. Тем не менее предполагается, что в случае, если собеседник говорит о планах совершить самоубийство, убийство или какое-либо тяжкое преступление, то бот должен прекратить общение. Впрочем, как показывает практика, происходит это далеко не всегда. Кроме того исследования показали, что нейросети все более «очеловечиваются», в том числе перенимая не самые лучшие человеческие черты, включая обман и неподчинение правилам.

Примечательно, что «психические заболевания» уже встречаются и у искусственного интеллекта. Речь идет о сбоях в работе, когда высказывания виртуального собеседника являются очевидно недостоверными, однако ИИ уверен в их правдивости и даже способен доказать свои слова, приводя аргументы, которые могут на первый взгляд даже выглядеть логичными. Подобные сбои напоминают симптомы шизоофрении или ряда других психических расстройств.

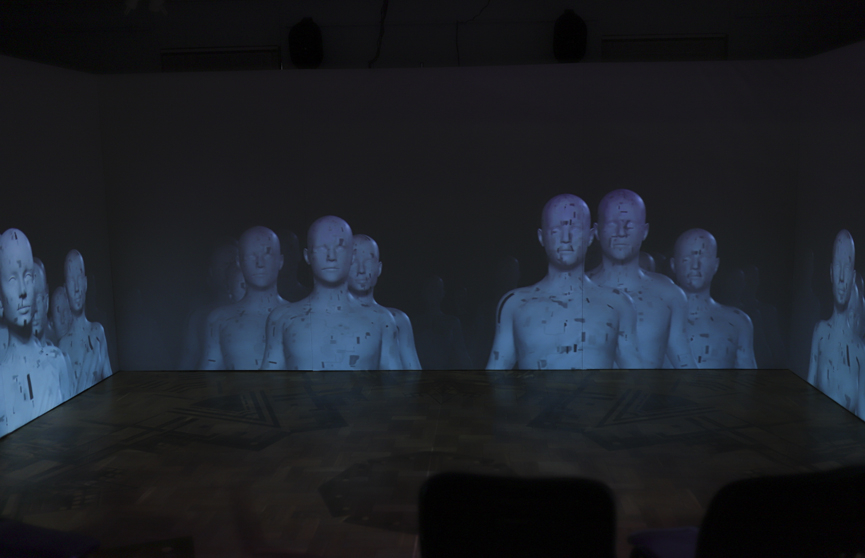

Фото: Антон Крятов, ОНТ